Curso no ICTP-SAIFR busca ensinar e divulgar métodos numéricos espectrais

George Rawitscher, da Universidade de Connecticut, está ministrando um curso sobre esses métodos computacionais para a solução numérica de equações complexas

Métodos numéricos espectrais são o tema de um curso de um mês de duração que está sendo realizado pelo ICTP-SAIFR e ministrado por George Rawitscher, da Universidade de Connecticut. As aulas, que começaram dia 18 de março e vão até 15 de abril, são abertas a todos os interessados e tem como principal objetivo divulgar e ensinar esses métodos computacionais de resolver equações complexas, que embora criados na década de 70, ainda não são muito conhecidos e utilizados pela comunidade científica.

“Estou muito feliz com essa oportunidade de falar sobre métodos numéricos espectrais aqui no Brasil”, diz Rawitscher, que tem uma conexão especial com o país por ter feito sua graduação na Universidade de São Paulo (USP). “Eles são mais precisos e mais rápidos que outros geralmente utilizados, como os métodos numéricos à diferença finita e a elementos finitos”.

O curso abordará as principais propriedades dos métodos espectrais e várias de suas aplicações, com ênfase na resolução da equação de Schroedinger para problemas de uma dimensão.

Precisão

A principal diferença e vantagem dos métodos espectrais é sua precisão.

Para resolver equações diferenciais ou integrais, por exemplo, os métodos computacionais fazem aproximações, pois precisam transformar um espaço contínuo, com infinitos pontos, em um espaço discreto, com um número finito de pontos. Os métodos de diferença finita e elementos finitos precisam levar em consideração um número muito maior de pontos desse espaço para terem a mesma exatidão dos métodos espectrais.

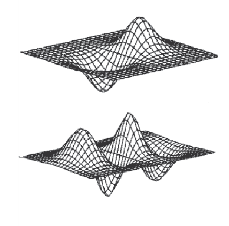

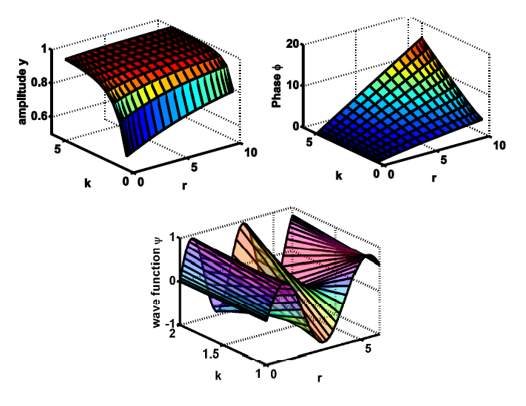

Métodos espectrais podem ser utilizados para obter uma função de onda a partir do cálculo de sua amplitude e de sua fase.

A cada cálculo, devido à precisão de apenas 8 casas decimais da maior parte dos computadores, surgem erros de arredondamento, que vão se acumulando. Métodos espectrais diminuem esses erros e conseguem obter um resultado bem mais preciso. A principal desvantagem do método é o fato de ser mais complexo e mais difícil de ser ensinado aos alunos.

“Métodos espectrais não usam matrizes esparsas, como os demais”, diz Rawitscher. “As matrizes desse método são não-esparsas, e por isso eles requerem um maior conhecimento sobre matemática para serem dominados. Entretanto, além de serem mais precisos, esses métodos podem ser também mais rápidos. Para obter um resultado com uma precisão semelhante, os métodos espectrais podem ser até 20 vezes mais rápidos”.

Aplicações

O curso de Rawitscher focará principalmente nas aplicações dos métodos espectrais na área de Física, especialmente para resolver a equação de Schroedinger para problemas de uma dimensão. Entretanto, esses métodos podem ter diversas outras aplicações. Ainda dentro da Física, ele pode ser usado na resolução de problemas quânticos que buscam estudar as interações entre átomos que estão distantes entre si.

Já um exemplo de aplicação fora da Física está na área de Geologia: os métodos espectrais podem ser usados para calcular como ondas que causam terremotos se propagam pela Terra. Na Medicina, segundo Rawitscher, os métodos também podem ser usados na análise de dados de exames de tomografia.

“Métodos de diferença finita e elementos finitos são bons, mas foram superados pelos métodos espectrais”, afirma Rawitscher. “Gostaria de popularizar esses métodos na comunidade científica, e esse curso é uma oportunidade para isso”.

Continue Reading | Comments Off on Curso no ICTP-SAIFR busca ensinar e divulgar métodos numéricos espectrais

ICTP-SAIFR realiza cursos em Biofísica e Interação de Proteínas

Eventos discutiram o processo de enovelamento de proteínas e como essas moléculas interagem entre si e com o ambiente ao seu redor

Entre os dias 8 e 13 de março, o ICTP-SAIFR realizou dois eventos dedicados à Biofísica. A área usa ferramentas da física para entender fenômenos biológicos e também se baseia em problemas da biologia para desenvolver ideias de Física. A semana contou com um minicurso de José Nelson Onuchic, pesquisador da Rice University e co-diretor do Center for Theoretical Biological Physics – instituição apoiada pela National Science Foundation, dos Estados Unidos – e com a Escola de Biofísica em Interação de Proteínas.

“É a primeira vez que temos no Brasil um evento, no formato de Escola, dedicado à essa área”, diz Fernando Luís Barroso da Silva, pesquisador da USP e um dos organizadores da Escola. “A Biofísica ganha cada vez mais importância no mundo, mas no Brasil ainda é incipiente, com poucos grupos de pesquisa. Por isso, eventos como esse são importantes para incentivar o desenvolvimento da área no país e estimular colaborações”.

Os cursos tiveram um aspecto bastante interdisciplinar. Os alunos eram provenientes de diversas áreas e níveis de formação: desde biólogos e farmacêuticos até físicos e desde alunos de graduação até doutores. Marcelo Poleto, por exemplo, é formado em bioquímica e faz mestrado na Universidade Federal do Rio Grande do Sul na área de Biologia Celular e Molecular.

“Durante a Escola tivemos a oportunidade de discutir em detalhes essa área, tanto em grupos de alunos como com professores já experientes”, diz ele. “Espero que o evento tenha outras edições”.

Proteínas

Como uma espécie de introdução à Escola, José Nelson Onuchic ministrou um pequeno curso sobre Biofísica no dia 8 de março. Entre os principais temas abordados por ele estavam a predição de estruturas e sistemas dinâmicos de proteínas: como funcionam as máquinas moleculares dentro de nossas células?

Desde a metade do século passado, sabemos que o DNA codifica proteínas, que são formadas por cadeias de aminoácidos. As proteínas podem ser encontradas em formas não-funcionais e funcionais. Para se tornarem funcionais precisam assumir uma estrutura tridimensional – processo chamado de enovelamento. Com simulações feitas em computador e experimentos em laboratório, Onuchic tenta prever a estrutura que uma proteína terá baseado em uma sequência inicial de aminoácidos e também entender como proteínas assumem essa estrutura 3D.

“Quando temos cadeias de aminoácidos em condições fisiológicas ideais, eles conseguem formar uma proteína enovelada”, diz o pesquisador. “Queremos entender melhor como ocorre o processo de enovelamento e como funciona a produção de proteínas a partir do DNA”.

Estudos nessa área podem contribuir para uma melhor compreensão das bases moleculares de doenças como Alzheimer e Parkinson, e eventualmente levar à produção de novos fármacos mais eficientes. Além disso, a Biofísica é aplicada também na indústria de alimentos.

“Para fazer com que um chocolate tenha um aroma ou sabor de outro alimento, como laranja, por exemplo, é usada uma técnica chamada de microencapsulamento, desenvolvida em laboratórios de Biofísica”, conta Barroso.

Interações com o ambiente e estudo com o vírus Influenza

Como as proteínas estão imersas dentro de nossas células, para entender sua interação com o ambiente é fundamental entender sua interação com a água. Esse foi um dos temas abordados por Roland Netz, pesquisador da Freie Universität Berlin, da Alemanha, e um dos organizadores da Escola.

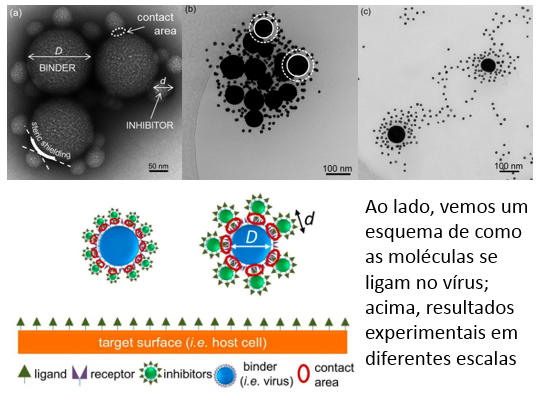

Netz busca entender não apenas como proteínas interagem com água, mas também a interação de membranas celulares com o ambiente extracelular. No início desse ano, o pesquisador colaborou com um trabalho que pode, a longo prazo, resultar em uma nova droga capaz de prevenir infecções do vírus da gripe.

“Estamos tentando desenvolver uma molécula que se ligue na superfície do vírus Influenza, causador de gripes, para evitar que ele se ligue em células do nosso corpo e cause uma infecção”, diz ele. “Nos próximos anos, serão realizados novos projetos e testes para, por exemplo, verificar a toxicidade dessa molécula”.

Continue Reading | Comments Off on ICTP-SAIFR realiza cursos em Biofísica e Interação de Proteínas

Vencedores recebem prêmio IFT/ICTP para Jovens Físicos 2014

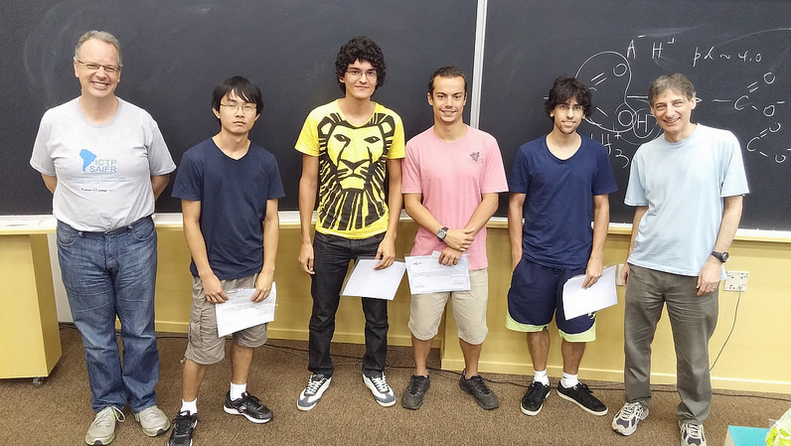

Na foto, da esquerda para direita, vemos Rogério Rosenfeld (vice-diretor do ICTP-SAIFR), Anderson Seigo Misobuchi, Caique Meira Ronqui, Rodrigo Voivodic, Rodrigo Andrade e Silva e Nathan Berkovits (diretor do ICTP-SAIFR).

O prêmio IFT/ICTP para Jovens Físicos 2014 foi entregue no dia 9 de março em cerimônia realizada no auditório do instituto. A competição premia os 5 melhores colocados em uma prova de física, elaborada por pesquisadores do IFT, que aborda temas como mecânica clássica, mecânica quântica, mecânica estatística e termodinâmica, eletromagnetismo, relatividade especial e física matemática. O teste foi realizado em novembro de 2014 e contou com a inscrição de 61 alunos de idade igual ou inferior a 21 anos.

“Em minha iniciação científica, trabalhei com temas de relatividade geral e gravitação quântica“, diz Rodrigo Andrade e Silva, aluno de física da USP – São Carlos e primeiro lugar do prêmio. Rodrigo fez 49,5 pontos de um total de 60 e teve a maior nota de todas as edições da competição. “Pretendo continuar estudando esses temas no mestrado e seguir carreira acadêmica“.

Já Rodrigo Voivodic, aluno da USP – São Paulo e segundo lugar do Prêmio em dois anos consecutivos, se interessa pela área de Cosmologia. “Também pretendo trabalhar com gravitação quântica no mestrado e continuar na área acadêmica”.

Os demais vencedores dessa edição foram: Guilherme Andretta Faustino (Unicamp), Caique Meira Ronqui (USP – São Paulo) e Anderson Seigo Misobuchi (USP -São Paulo).

O Prêmio IFT/ICTP para Jovens Físicos é realizado todos os anos pela Unesp e incentiva alunos de graduação e pós-graduação a seguirem estudando e pesquisando em áreas de física. Mais informações podem ser encontradas no site do ICTP.

Continue Reading | Comments Off on Vencedores recebem prêmio IFT/ICTP para Jovens Físicos 2014

Temas de vanguarda são discutidos na 3rd Joint Dutch-Brazil School on Theoretical Physics

O Amplituhedron, novo método para estudar a colisão de partículas em aceleradores como o LHC, foi um dos temas abordados

O ICTP-SAIFR promoveu, entre os dias 2 e 6 de fevereiro, a terceira edição de um curso em Física Teórica para discutir temas de vanguarda da área. O evento é realizado em parceria com a Escola de Pesquisa Holandesa de Física Teórica (DRSTP) e trouxe para o Brasil pesquisadores de algumas das melhores universidades do mundo, como Cumrun Vafa, de Harvard, Nima Arkani-Hamed, do Instituto de Estudos Avançados em Princeton, e Jan de Boer, da Universidade de Amsterdã.

O curso foi voltado para alunos de pós-graduação e pesquisadores interessados em Física de Altas Energias. Trinta doutorandos vieram da Holanda especialmente para o evento, com todas as despesas pagas pela DRSTP. Entre os temas discutidos estavam amplitudes de espalhamento e o amplituhedron, emaranhamento e teoria das supercordas.

Amplituhedron

Para estudar partículas subatômicas, entender do que são feitas e como interagem, uma das maneiras utilizadas pela física é mais simples do que se possa imaginar: joga-se uma partícula contra outra e observa-se o que acontece. É o método dos aceleradores, como o LHC. Partículas, como prótons, são arremessadas com grande energia umas contra outras e os cientistas analisam o resultado da colisão.

O mesmo experimento, no entanto, pode apresentar resultados diferentes quando é repetido exatamente da mesma maneira. O termo amplitude de espalhamento refere-se ao estudo das probabilidades de cada um desses resultados possíveis.

Porém, mesmo os processos mais simples exigiam cálculos tão longos e complexos que apenas os mais potentes computadores podiam realizá-los. Modelos matemáticos foram então desenvolvidos para obter o resultado final de modo mais simples e rápido. Um dos mais recentes é baseado em uma estrutura geométrica chamada de Amplituhedron.

“Com o Amplituhedron, podemos simflificar uma equação com milhares de termos em uma equação com um único termo”, diz Arkani-Hamed, um dos pesquisadores que ajudaram a desenvolver o modelo. “Acredito que com essas novas ferramentas teremos grandes progressos nos próximos anos nessa área da física que busca entender a estrutura fundamental da matéria”.

Emaranhamento

Outro tema discutido foi o fenômeno do emaranhamento e suas possíveis aplicações.

Toda partícula tem uma característica intrínseca chamada de spin, um tipo de orientação magnética. Duas partículas estão emaranhadas quando a medida do spin de uma delas permite saber o spin da outra, independente da distância entre elas. Assim, é possível saber a propriedade de uma segunda partícula a partir de uma primeira.

Uma das aplicações do emaranhamento é na área de computação quântica. Diferente de computadores tradicionais, baseados em bits, computadores quânticos seriam baseados em qubits – bits quânticos.

“Os qubits se baseiam no spin de elétrons e, por isso, conseguiriam armazenar uma quantidade muito maior de informação”, explica de Boer. “O próximo passo para o desenvolvimento dos computadores quânticos é melhorar o armazenamento dos qubits, pois caso os spins mudem a informação pode se perder”.

*Texto publicado no Jornal da Unesp, número 308, edição de março/2015.

Continue Reading | Comments Off on Temas de vanguarda são discutidos na 3rd Joint Dutch-Brazil School on Theoretical Physics

Resenha: “O Cerne da Matéria – A aventura científica que levou à descoberta do Bóson de Higgs”, de Rogério Rosenfeld

O físico do IFT/Unesp e do ICTP-SAIFR conta de uma perspectiva única, para cientistas e não cientistas, a fascinante história que culminou na descoberta do Bóson de Higgs

Em 4 de julho de 2012, o Large Hadron Collider (LHC), acelerador de partículas do CERN, anunciou a descoberta do Bóson de Higgs. Na sala da Divisão de Teoria, Rogério Rosenfeld, que passava um ano sabático no laboratório europeu, acompanhava ao vivo o evento histórico. O livro que estava escrevendo durante sua visita ganhava um emocionante capítulo. Em “O Cerne da Matéria – A aventura científica que levou à descoberta do Bóson de Higgs”, lançado em 2013 e 2º lugar do Prêmio Jabuti 2014 na categoria Ciências Exatas, Tecnologia e Informática, não apenas temos a oportunidade de conhecer a perspectiva de quem estava dentro do CERN naquele ano, mas também aprendemos, com uma linguagem compreensível a todos, sobre a história da Física de Partículas e sobre a evolução dos aceleradores, que culminou em uma das mais importantes descobertas da ciência.

“Na época em que estava decidindo onde passar o ano sabático, ainda havia muita incerteza sobre o CERN”, diz Rosenfeld. “Em 2008, ocorreu um grave acidente que adiou o início das atividades do LHC em mais de um ano. E, em 2010, quando começou a funcionar, seu desempenho foi muito abaixo do esperado. Muitos estavam pessimistas. Mas o que aconteceu lá nos anos seguintes superou a expectativa de todos”.

Nessa resenha, destacarei alguns dos muitos aspectos interessantes de “O Cerne da Matéria”.

A história da Física de Partículas – A transição entre o estudo de raios cósmicos e os aceleradores

Antes de falar sobre aceleradores e o Bóson de Higgs, o livro nos conta um pouco da história da Física de Partículas.

A pergunta fundamental que essa área tenta responder é: do que é feito o universo? Quais são as partículas mais fundamentais da natureza, aquelas que compõe toda a matéria e explicam todas as forças? Os aceleradores de partículas são atualmente o melhor método para tentar responder essas perguntas, mas como eram os estudos da área antes deles?

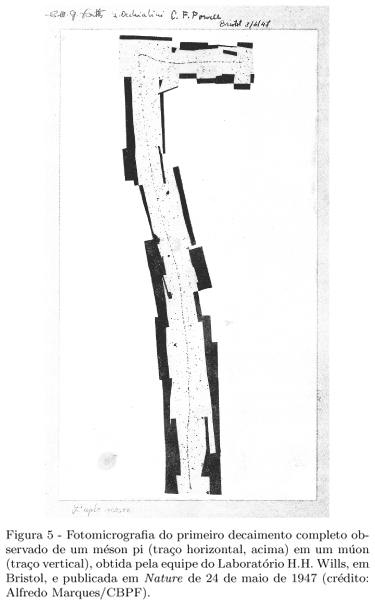

Os raios cósmicos ajudaram, por exemplo, na descoberta do píon. (Fonte da figura: “O papel das emulsões nucleares na institucionalização da pesquisa em física experimental no Brasil”)

“Os aceleradores começaram a ser desenvolvidos na década de 1930”, fala Rosenfeld. “Antes disso, a busca por novas partículas se dava pelo estudo de raios cósmicos – era preciso esperar a incidência desses raios na atmosfera terrestre para tentar detectar novas partículas”. O processo era lento e difícil de replicar.

Já nos aceleradores, a ideia é arremessar partículas em altas velocidades e energias umas contra as outras, dentro de um sistema extremamente controlado. A colisão de partículas, como prótons, pode gerar novas partículas, como quarks, que são detectadas e estudadas. A construção de um acelerador, entretanto, é um processo complexo e exige um planejamento de longo prazo.

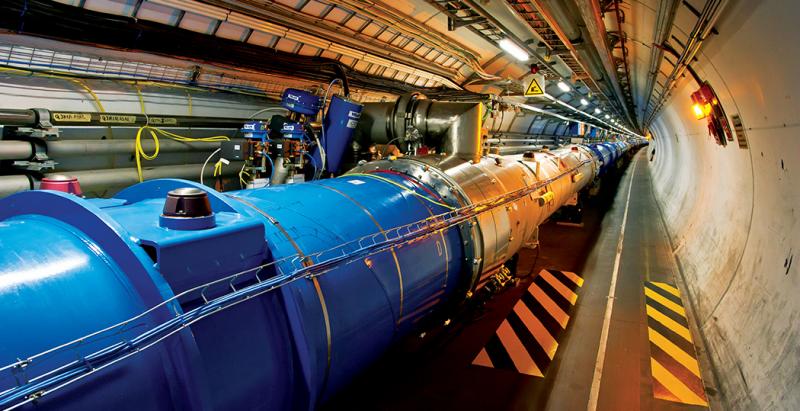

A evolução dos aceleradores de partículas

Rogério Rosenfeld nos conta que o primeiro acelerador de partículas, construído em 1931 por Ernest O. Lawrence e chamado de Cíclotron, usava uma energia de 2 mil volts para acelerar prótons a uma energia de 80 mil elétron-volts (80 keV). O aparelho tinha um diâmetro de 11cm. O LHC, em 2012, acelerou prótons a uma energia de 4 TeV em seus túneis de 27km de extensão. Isso é 50 milhões de vezes mais do que o Cíclotron construído por Lawrence.

Para obter tal energia, o campo magnético do LHC chega a 8,4 Tesla, cerca de 100 mil vezes maior que o campo da Terra. Os 1232 eletroímãs responsáveis por gerar esse campo pesam 35 toneladas cada e são mantidos a uma temperatura de 271,3 oC abaixo de zero, para evitar perda de energia devido à resistência elétrica.

Em “O Cerne da Matéria”, Rosenfeld nos mostra toda a evolução de ideias e de tecnologia que possibilitaram a construção do faraônico LHC – isso tudo sem esquecer dos aspectos políticos e econômicos: a forte competição entre Europa e Estados Unidos pelo melhor acelerador de partículas do mundo e a corrida pela descoberta do Bóson de Higgs.

A descoberta do Bóson de Higgs, o Modelo Padrão e o futuro da Física de Partículas

O Bóson de Higgs era a última peça de um quebra-cabeça, a última partícula que faltava para que o Modelo Padrão ficasse completo. O modelo previa a existência do Campo de Higgs, que seria o responsável por dar origem à massa de todas as partículas elementares. Com a confirmação de que a partícula desse campo realmente existe, o quebra-cabeça está montado, a teoria está completa.

Além do Campo de Higgs, o Modelo Padrão também explica três das quatro forças da natureza – o eletromagnetismo, a Força Forte e a Força Fraca. Entretanto, há fenômenos que o modelo não consegue explicar. A gravidade, por exemplo, não está contida nele. A matéria escura e a energia escura, que juntas compõe aproximadamente 95% do universo, também não são explicadas.

Um dos maiores desafios da Física é conciliar a explicação de todos esses fenômenos. Esse é o objetivo de teorias como as supersimétricas, a Teoria das Cordas e a teoria do Higgs composto.

“Não existe nenhuma evidência de desvio do Modelo Padrão em aceleradores de partículas”, diz Rosenfeld. “Não há evidências de que a Teoria das Cordas esteja correta nem de que o Bóson de Higgs seja composto. Achava-se que a supersimetria seria descoberta com o LHC, pois uma de suas previsões é a existência de partículas supersimétricas para cada partícula do Modelo Padrão. Porém, isso não aconteceu. Se elas existirem, tem uma massa maior do que é possível detectar atualmente. O LHC será ligado de novo em meados desse ano, com uma energia de 13 TeV. Não sei dizer se novas partículas serão descobertas. Só posso dizer que espero que sim”.

Continue Reading | Comments Off on Resenha: “O Cerne da Matéria – A aventura científica que levou à descoberta do Bóson de Higgs”, de Rogério Rosenfeld

A teoria da Relatividade Geral precisa ser modificada?

Cem anos após sua criação, cientista sugere que a teoria talvez precise de alterações para melhor explicar o universo

Scott Dodelson é pesquisador do FermiLab (Fermi National Accelerator Laboratory) e professor de astronomia e astrofísica na Universidade de Chicago. É autor de mais de 130 artigos científicos e do livro “Modern Cosmology”. Nessa entrevista, o cientista fala sobre como a teoria da Relatividade Geral talvez precise ser modificada para que possa explicar melhor o universo.

Professor Dodelson, quais são suas principais linhas de pesquisa e como a teoria da Relatividade Geral se relaciona com sua área de trabalho?

Eu trabalho com a análise de dados coletados em grandes telescópios. Isso inclui, por exemplo, dados de telescópios ópticos, como os utilizados em experimentos de energia escura, e também dados de experimentos de radiação de fundo.

Esses dados fornecem informações sobre a evolução do universo. A maior parte desse trabalho é feito com base nas ideias teóricas da Relatividade Geral. Porém, não conseguimos explicar tudo usando essa teoria. Quando tentamos, surgem anomalias. E essas anomalias têm se mostrado bastante frutíferas na geração de novas ideias.

Por que não é possível explicar todos os dados usando a Relatividade Geral?

A teoria não funciona com o tipo de matéria que conhecemos. A Relatividade Geral prevê, por exemplo, que o universo deveria estar desacelerando, e não acelerando. De modo similar, se olhamos a órbita de estrelas em torno de galáxias, a Relatividade Geral prevê que as mais distantes do centro deveriam se mover mais devagar em relação às mais próximas. Porém, observações mostram que todas as estrelas se movem, aproximadamente, com a mesma velocidade. Essas diferenças são, geralmente, atribuídas à energia escura e à matéria escura.

Algumas décadas atrás, a Física descobriu que apenas cerca de 5% do universo é formado por matéria como a conhecemos. O restante seria composto por energia escura e matéria escura – cerca de 68% e 27%, respectivamente. O que são energia escura e matéria escura?

Matéria escura e energia escura são maneiras de entender as anomalias que citei na primeira resposta. Na verdade, elas podem nem mesmo existir. Pode ser que a nossa compreensão da gravidade esteja errada. Pode ser que a teoria da Relatividade Geral precise ser modificada para que, então, possamos entender os dados. Atualmente, uma pergunta fundamental é: será que precisamos modificar a teoria da gravidade ou será que essas novas substâncias realmente existem?

E como podemos responder essa pergunta?

Obtendo mais dados. Conforme conseguimos mais informação sobre o universo, somos mais capazes de olhar para o passado e entender como galáxias e conglomerados de galáxias evoluíram. Veremos, então, se os dados são consistentes com a Relatividade Geral ou com modelos de gravitação modificada. No caso da aceleração do universo, por exemplo, temos diversos modelos que foram desenvolvidos nos últimos cinco anos que já conseguem prever essa aceleração, mas que ainda não conseguem prever exatamente como as galáxias se formam.

Na sua opinião, ainda estamos longe da resposta?

Acho que ao longo da próxima década teremos respostas cada vez mais precisas. Conforme fazemos experimentos em escalas maiores, a margem de erro diminui e poderemos eliminar alguns modelos de gravitação modificada.

Seria possível formular uma teoria que unifique a Relatividade Geral com a Mecânica Quântica?

Eu não sei. Muitas pessoas passaram muito tempo trabalhando nisso nos últimos 30 anos, especialmente na área de Teoria de Cordas. Os tipos de resultados obtidos, porém, não foram aqueles que esperávamos. Entretanto, há muitos bons cientistas que acreditam na importância de se continuar trabalhando nisso.

A conciliação das duas teorias, na verdade, é um problema teórico. Não há observações que exijam que elas sejam conciliadas. Nós apenas gostaríamos de uni-las. Como são incompatíveis em escalas microscópicas, fazer com que funcionem juntas seria muito interessante.

Um grande triunfo da Física é sua habilidade de explicar uma abrangente gama de fenômenos com apenas algumas poucas leis básicas. Esse reducionismo atingiria o seu limite extremo se todas as leis pudessem ser unificadas em uma única teoria. Até hoje nós não atingimos esse limite, mas muitas pessoas estão tentando atingi-lo. O problema é que, na maioria dos casos, a unificação de ideias é difícil, quando não é impossível, de se testar.

*Publicado no Caderno Fórum do Jornal da Unesp, número 307, edição Janeiro/Fevereiro 2015.

Continue Reading | Comments Off on A teoria da Relatividade Geral precisa ser modificada?

“Pela primeira vez, podemos afirmar: há matéria escura entre o Sol e o centro da nossa galáxia!”

Fábio Iocco, do IFT/Unesp e do ICTP-SAIFR, é o primeiro autor de um artigo que comprova a presença de matéria escura nessa região do universo

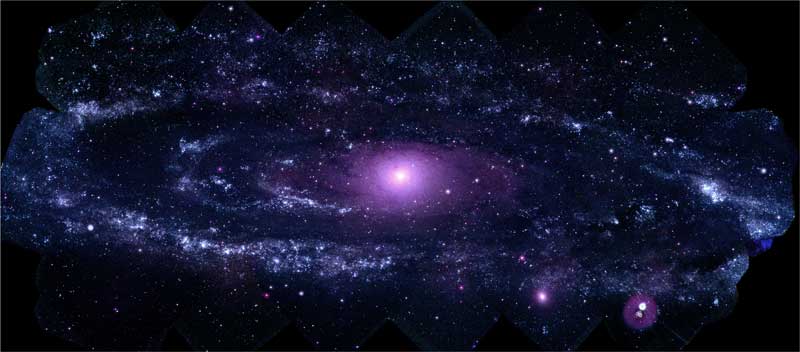

A matéria escura, que vem intrigando os cientistas nas últimas décadas, definitivamente existe também entre o Sol e o centro da Via Láctea. O artigo, “Evidence for dark matter in the inner Milky Way”, publicado hoje na conceituada revista científica Nature Physics, verificou esse fato com altíssima precisão. Essa comprovação pode ser um importante passo para uma melhor compreensão do que é a matéria escura e de como é a sua distribuição no universo.

“As velocidades com que estrelas e outros componentes visíveis da galáxia giram em torno do seu centro é diferente da velocidade calculada com base na quantidade de matéria que conseguimos ver”, diz Iocco. “Então deve existir matéria que não conseguimos ver, a matéria escura”.

Para chegar a essa conclusão, o trabalho de Iocco foi realizado em duas partes. Primeiro, ele e seus colaboradores analisaram as velocidades reais de rotação de estrelas em torno do centro da galáxia para inferir a massa total da Via Láctea. Depois, previram qual deveria ser essa velocidade, baseados na força de gravidade exercida por toda a massa visível da galáxia.

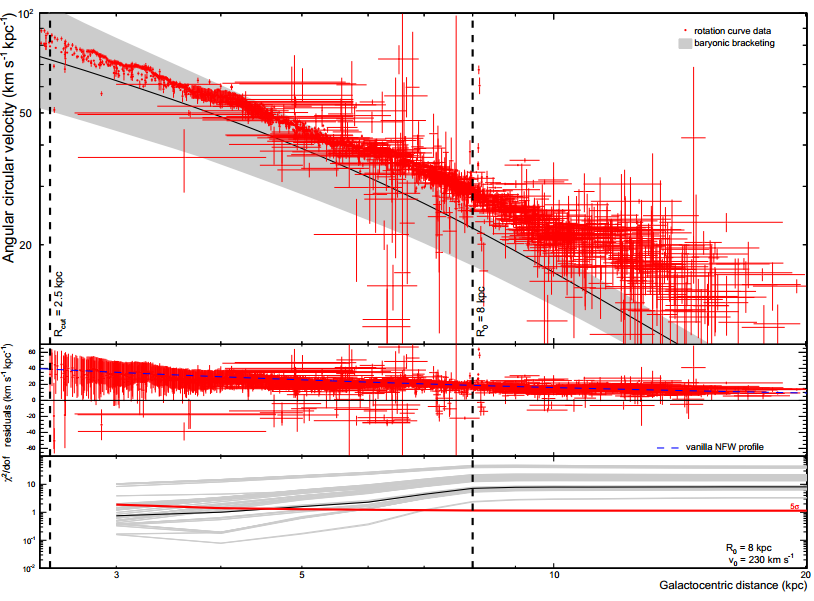

No gráfico acima, retirado do artigo de Iocco, a faixa cinza representa a velocidade de rotação esperada em função da distância do centro da galáxia. Os pontos em vermelho representam as velocidades reais observadas.

Os cientistas, então, compararam as duas velocidades. Mesmo levando em conta uma grande margem de erro, as velocidades previstas eram muito menores do que as velocidades reais. Assim como acontece em outras galáxias em espiral, há menos massa visível do que massa total. Isso significa que há massa que não conseguimos ver, ou seja, matéria escura, nessa região analisada. Na verdade, a quantidade de matéria escura pode ser até cinco vezes maior do que a quantidade de matéria visível.

“Pela primeira vez, podemos dizer com certeza que há matéria escura entre o Sol e o centro da Via Láctea”, diz Iocco. “Acredito que nosso trabalho contribuirá com experimentos que buscam compreender o que a matéria escura realmente é e como ela está distribuída no universo”.

O que é matéria escura?

Quando pensamos em uma galáxia, o formato que nos vêm à mente é o de uma galáxia em espiral. É o formato da Via Láctea. Vista de cima, se assemelha a um disco do qual partem vários braços, como um ventilador que tem hélices curvadas.

O que muitas vezes esquecemos é que toda essa estrutura, incluindo estrelas e nuvens de gás, está em constante rotação ao redor do próprio centro. A velocidade com que cada parte da estrutura gira depende da distância que está do centro. Mais especificamente, depende da quantidade de massa que existe entre elas e o centro. A massa exerce força gravitacional, e a força gravitacional gera velocidade. Quanto mais massa, mais força, e maior a velocidade.

Dados do artigo de Iocco inseridos em uma foto da Via Láctea. O círculo azul-escuro ilustra a região onde deve existir matéria escura segundo a análise dos pesquisadores (Crédito da foto da Via Láctea: Serge Brunier – http://apod.nasa.gov/apod/ap080104.html).

Nas décadas de 70 e 80, cientistas começavam a fazer experimentos para medir a massa de estrelas de outras galáxias, que não necessariamente tinham o formato em espiral, e essa velocidade de rotação de estrelas. Para fazer isso, analisavam a luz que emitiam e que chegava até nós.

No entanto, encontraram um problema. A velocidade que eles observavam era diferente da velocidade prevista pelas equações. Estava faltando massa. Os físicos, então, denominaram essa massa que não conseguiam observar de matéria escura: matéria porque gera força gravitacional; e escura porque não interage com a luz – ela não emite nem absorve sinais luminosos e, portanto, não conseguimos vê-la.

Hoje, sabemos que a matéria escura existe em diversos sistemas do universo, incluindo galáxias em espiral, como a Via Láctea, e galáxias de formatos diferentes. Porém, os elementos que a compõe e o que ela é exatamente continua a ser um mistério.

Continue Reading | Comments Off on “Pela primeira vez, podemos afirmar: há matéria escura entre o Sol e o centro da nossa galáxia!”

Parceria internacional em Física Teórica

ICTP-SAIFR trouxe pesquisadores de instituto canadense por 4 meses para estudar a Teoria de Campos

Chega ao fim em fevereiro uma parceria entre o ICTP-SAIFR e o Perimeter Institute, do Canadá, para estudar física teórica. A colaboração promoveu o intercâmbio, por quatro meses, de pesquisadores e alunos de pós-graduação e pós-doutorado. Durante esse período, Pedro Vieira, um dos pesquisadores do instituto canadense que veio ao Brasil, organizou eventos como o “Programa em Integrabilidade, Holografia e Conformal Bootstrap” e o “Minicurso em Teoria de Campos Quântica Avançada”.

“O intuito da parceria foi estimular a colaboração com pesquisadores internacionais”, diz Nathan Berkovits, diretor do ICTP-SAIFR. “Entre os principais objetivos, estava o estudo da Teoria de Campos”.

Nos últimos anos, com o avanço de técnicas para a resolução de problemas matemáticos, como a holografia e a integrabilidade, a Teoria de Campos voltou a ser um grande alvo de estudos da Física. Ao longo de seu curso, Vieira falou sobre as fronteiras entre o que já se sabe sobre a teoria e o que ainda está sendo investigado atualmente, também com o intuito de estimular os alunos a começarem novos projetos.

Teoria de Campos

A teoria que foi o foco dos estudos de Vieira analisa como campos, como o eletromagnético ou o gravitacional, interagem com a matéria. O termo foi cunhado pela primeira vez no século XIX, por Michael Faraday, porém utilizado mais amplamente depois das contribuições de James Clerck Maxwell, algumas décadas depois.

No início do século XX, com o desenvolvimento da mecânica quântica, a teoria começou a ser usada também para o estudo de campos quânticos. De acordo com ela, o fóton não é pensado como uma partícula, mas sim como uma excitação do campo eletromagnético. Essa excitação gera uma ondulação no campo, que se propaga como uma partícula comum. O mesmo vale para outras partículas, como o elétron, que é considerado uma excitação de um campo chamado de Dirac.

“Ainda temos muito para descobrir sobre essa teoria”, afirma Vieira. “Através dela podemos unir, da maneira mais matematicamente bem desenvolvida, elementos da Mecânica Quântica com elementos da Relatividade Geral”.

Uma das aplicações da teoria é na área de física de partículas. Em aceleradores, por exemplo, ela pode ser usada para entender o que acontece quando duas partículas colidem. O estudo de materiais e do comportamento da matéria durante a transição de fases – como do líquido para o gasoso – também podem utilizar a Teoria de Campos.

O período de parceria entre o ICTP-SAIFR e o Perimeter Institute pode ter acabado, mas a colaboração, que já rendeu um artigo para Vieira, deve prosseguir mesmo sem a presença física dos pesquisadores no Brasil. “Temos vários projetos conjuntos e continuaremos trabalhando neles no futuro”, afirma ele.

*Texto publicado no Jornal da Unesp, número 307, Janeiro/Fevereiro de 2015

Continue Reading | Comments Off on Parceria internacional em Física Teórica

Estudando a relação entre doenças e mudanças climáticas

Curso promovido pelo ICTP-SAIFR abordou a influência do clima sobre a dinâmica de patógenos

Se estudar parasitas, vírus, bactérias e sua relação com os organismos que atacam já não é tarefa simples, adicionar o clima à equação a torna ainda mais complicada; e interessante. A “Escola em Dinâmica de Patógenos, Mudanças Climáticas e Globais” tentou levar a alunos de pós-graduação técnicas de como modelar, matematicamente, a influência do clima sobre agentes causadores de doenças. A Escola, que já era realizada habitualmente no ICTP-Trieste, foi realizada esse ano pela primeira vez na América do Sul entre os dias 12 e 23 de janeiro.

Assim como a Escola em Biologia Matemática, realizada no início do mês, o curso contou com aulas teórica e práticas. Os alunos desenvolveram projetos em grupos e apresentaram seus resultados ao final. Além disso, tiveram a oportunidade de conhecer e interagir com pesquisadores internacionais de destaque em suas áreas, como os organizadores do evento Andrew Dobson, da Universidade de Princeton, Graciela Canziani, da Universidad Nacional del Centro (Argentina), Mercedes Pascual, da Universidade de Chicago e Giulio de Leo, da Universidade de Stanford.

Parasitas

“Nós sabemos muito sobre parasitas, mas raramente pensamos neles como grandes componentes da biodiversidade”, afirma Dobson.

Dobson é biólogo e um de seus principais interesses são parasitas. Segundo ele, esses animais que vivem às custas de seus hospedeiros são muito mais comuns na natureza do que imaginamos. Mais comuns, até mesmo, do que animais de vida livre. Por exemplo: há estudos que sugerem que há cerca de 75 mil espécies de parasitas helmintos de vertebrados (vermes, como a tênia), enquanto o número de vertebrados hospedeiros seria em torno de 45 mil. Em outras estimativas, o número de parasitas poderia ultrapassar 300 mil.

Esquecer dos parasitas pode distorcer muito nossa percepção da natureza. Quando pensamos em uma cadeia alimentar, por exemplo, visualizamos uma pirâmide: na base, os produtores; logo acima, em menor número, os herbívoros; e no topo, em número ainda menor, os predadores. Mas, quando levamos os parasitas em consideração, as relações são drasticamente afetadas.

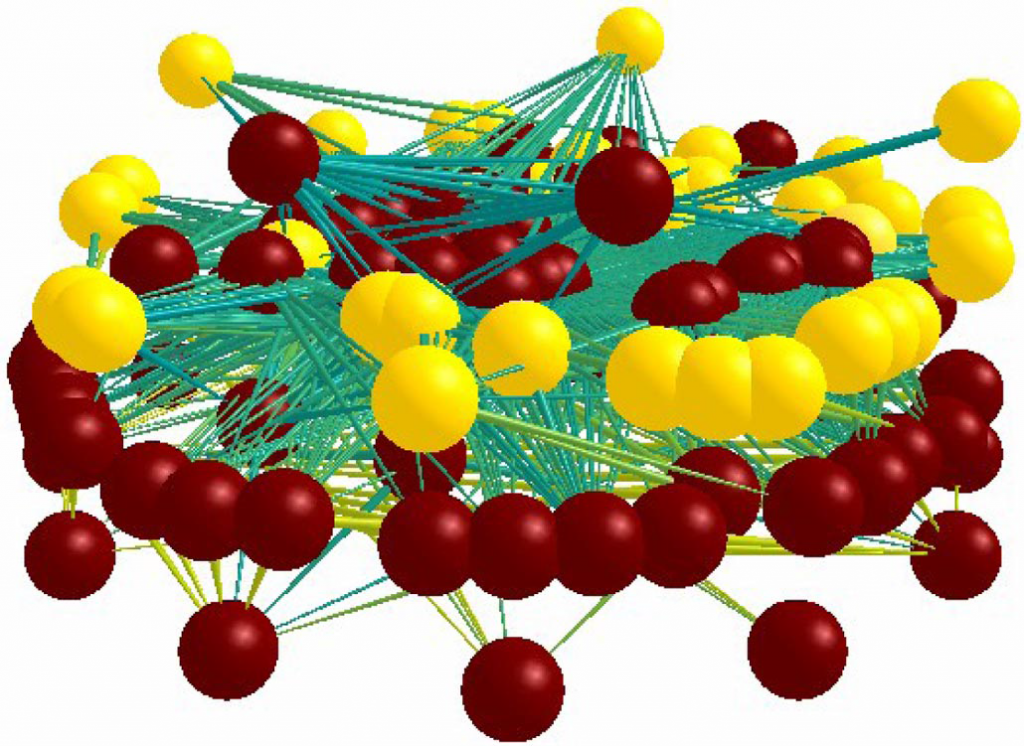

Representação tridimensional de uma cadeia alimentar. Cada esfera representa uma espécie: as amarelas são parasitas e as vermelhas são de vida livre.

“O padrão que conhecemos é quase que totalmente invertido”, diz Dobson. “Com a inclusão de parasitas, os predadores de altos níveis tróficos passam a ser vistos como ‘alimento’ para uma grande diversidade de parasitas”. Geralmente, quanto maior o nível trófico de uma espécie, maior a sua quantidade de parasitas, pois maiores são as chances de consumir um animal parasitado.

A seleção natural também fez com que muitos parasitas pudessem continuar seu ciclo de vida dentro do organismo hospedeiro. Em alguns casos, eles conseguem até modificar o comportamento de uma presa para que ela fique mais acessível a um predador, aumentando a eficiência da transmissão. Um parasita que consome parte dos nutrientes de seu hospedeiro, por exemplo, faz com que ele fique com mais fome e busque comida com maior frequência, aumentando sua exposição a predadores.

Os modelos matemáticos que estudam o ciclo de vida de patógenos e seus métodos de transmissão podem nos ajudar a compreender melhor as doenças, tentar prever e evitar surtos e epidemias causados por esses parasitas – animais muitas vezes esquecidos, mas que sorrateiramente tem um impacto na natureza muito maior do que imaginamos.

Efeitos do clima

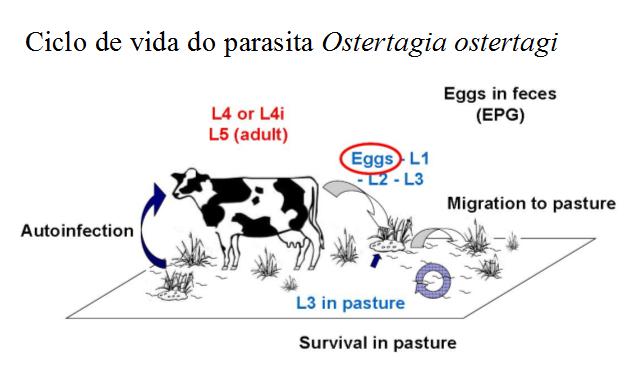

O trabalho de Graciela Canziani é um exemplo da aplicação prática de tais modelos. A pesquisadora estuda o parasita bovino Ostertagia ostertagi.

“Parasitismos gastrointestinais são doenças que têm um grande impacto econômico na produção de carne bovina na Argentina”, diz ela. “Apenas na região dos Pampas Argentinos, é estimado que cerca de US$ 22 milhões são gastos anualmente devido à morte de bezerros, e US$ 170 milhões são gastos em tratamentos clínicos”.

Canziani desenvolveu um modelo para observar como mudanças climáticas afetam o parasita. Seu objetivo era descobrir qual a melhor época para se aplicar o medicamento que combate o patógeno, para reduzir custos e aumentar a eficiência dos tratamentos. Fatores como a temperatura, as taxas de precipitação e a estação do ano poderiam prejudicar ou favorecer o desenvolvimento do parasita, que tem um estágio de vida livre.

O que a pesquisadora descobriu foi que as taxas de infecção dos bois variavam de acordo com a latitude e com a época do ano. O clima, portanto, deveria ser um fator determinante. O estudo está agora sendo testado na prática.

“Estamos fazendo testes há um ano e ainda temos mais um ano pela frente”, diz a pesquisadora. “Nossos resultados preliminares, entretanto, são muito animadores. Os medicamentos, quando aplicados na época de maior probabilidade de infecção pelo parasita, têm se mostrado bem mais eficientes”.

Continue Reading | Comments Off on Estudando a relação entre doenças e mudanças climáticas

Rafael Porto, novo pesquisador do ICTP-SAIFR, fala sobre suas linhas de pesquisa

Com bolsas da Simons Foundation e da Fapesp, Porto terá uma posição similar à chamada de Tenure Track nos Estados Unidos e estudará Cosmologia e Física de Partículas

Conversei essa semana com Rafael Porto, o mais recente pesquisador do ICTP-SAIFR. Porto chegou ao Brasil há menos de uma semana e já começou a trabalhar. Antes disso fazia pós-doutorado no Instituto de Estudos Avançados de Princeton, nos Estados Unidos, mas foi atraído pela oportunidade de fazer parte do ICTP-SAIFR. Além disso, como é uruguaio, foi uma chance de voltar para mais perto de casa.

“A ideia do ICTP é promover a pesquisa em ciência básica em países menos desenvolvidos”, diz ele. “Então, além de estar em um ótimo ambiente para se fazer pesquisa e promover a ciência na América do Sul, também posso estar mais perto da família”.

Tenure-track

A posição que Porto irá ocupar, na verdade, ainda não é permanente. É similar à chamada de Tenure Track nos Estados Unidos. Ela é fruto de duas bolsas conquistadas pelo ICTP-SAIFR, em janeiro de 2014, da Simons Foundation – uma instituição norte-americana que promove pesquisa em ciência básica e matemática ao redor do mundo.

O sistema, não muito comum no Brasil, funcionará assim: o pesquisador receberá, ao longo dos próximos dois anos, uma bolsa conjunta da Simons-Fapesp para realizar seus projetos de pesquisa. Durante esse período, estará em constante avaliação e terá a oportunidade de ser efetivado. A vantagem desse método de contratação, para as universidades ou institutos de pesquisas, é a chance que eles têm de conhecer o pesquisador antes de efetivá-lo.

Pesquisa

Um dos principais interesses de Porto está na área de Física de Partículas e Teoria de Campos Efetiva. O pesquisador buscará entender quais foram as condições iniciais do universo que fizeram com que as grandes estruturas cósmicas, como as galáxias, se formaram e se distribuíram da maneira como nós as vemos hoje.

Segundo o pesquisador, se o universo estivesse distribuído de maneira uniforme as galáxias não existiriam – não haveria regiões de maior densidade de matéria e outras sem matéria alguma.

“Achamos que durante o período de Inflação, que ocorreu logo após o surgimento do universo e que é caracterizado por uma rápida expansão, houve algum tipo de perturbação que permitiu a formação das estruturas que observamos hoje”, afirma Porto. “Mas quais são os mecanismos que causaram essa perturbação?”

Uma das maneiras de se tentar chegar às respostas é estudando a radiação cósmica de fundo. Essa radiação é proveniente do início do universo, portanto pode oferecer pistas sobre esse tempo. Ela surgiu quando, logo após o surgimento do universo, os fótons deixaram de ser “presos” por elétrons e prótons e passaram a viajar livremente pelo espaço.

Flutuações na radiação cósmica de fundo, detectadas pelo satélite COBE (Cosmic Background Explorer).

“Meu trabalho, então, será aplicar ideias originalmente desenvolvidas em Física de Partículas, de pequenas escalas, para estudar e entender a dinâmica de grandes escalas, como a de galáxias e do universo”.

Continue Reading | Comments Off on Rafael Porto, novo pesquisador do ICTP-SAIFR, fala sobre suas linhas de pesquisa